robots txt 파일 생성, 수정, 적용까지 총정리 가이드

백링크 작업 업체, 국내 1위 - 백링크프로

구글 상위 노출을 원하신다면, 백링크 작업을 해보세요!

이 글에서 얻을 수 있는 정보는,

'robots.txt 파일'이란 무엇인가, 설정하면 어떤점이 좋은가, 설정하는 방법과 확인하는 방법까지 robots.txt 에 관한 모든 정보를 담았습니다. 이 글을 끝까지 보시면 robots.txt 파일이 어떤 기능을 하는지, 어떻게 SEO에 도움이 되는지, 어떻게 수정하고 제출할 수 있는지를 전부 아실 수 있습니다. 필요한 정보를 잘 정리해서 가져가셔서 웹페이지 SEO에 도움이 되시기를 바랍니다.

그럼 시작하겠습니다.

robots txt 란?

네이버 구글 상위 노출을 위해서 해야하는 작업입니다.우리가 홈페이지를 만들면 자동으로 구글, 네이버, 빙 등에서 내 홈페이지를 발견해서 노출시켜주지 않습니다. 우리가 홈페이지를 만들었다고 각각의 사이트에 가서 말을 해주어야 합니다.

홈페이지가 생겼다는 말을 해주면, 검색사이트에서 보고를 받은 'AI 검색 엔진'이 수집하는 AI를 보내서 사이트를 수집하러 옵니다. 이 사이트를 수집하러 오는 AI가 웹 크롤러(검색엔진 크롤러)입니다.

이 '웹 크롤러'가 우리 홈페이지에 방문해서 홈페이지 안에 있는 링크들을 타고 다니면서 우리 홈페이지가 어떻게 생겼는지 파악하게 되는데, 이 파악을 더 쉽게 하도록 하는 것이 '사이트 맵'(sitemap.xml)입니다. (사이트맵에 관해 궁금하신분은 사이트맵을 클릭해서 확인해주세요.)

그리고 홈페이지에서 크롤링할 수 있는 경우 와 없는 경우를 명령해주는 지침서가 robots.txt 파일입니다. 여기에는 특정 크롤러(특정 사이트의 크롤러)를 선택해서 받을 수 있으며, 웹페이지 콘텐츠 크롤링 유무를 선택할 수도 있으며, 사이트맵의 위치를 알려줘서 크롤링을 더 빠르게 할 수도 있습니다.

처음 홈페이지를 방문했을 때, 우리 홈페이지에서 어떻게 행동을 해야하는지 AI에게 알려주는 지침서라고 생각하시면 이해하시기 편하실 것 같습니다.

robots.txt 파일을 업로드 해야하는 이유

robots.txt 파일을 업로드 해야하는 이유는 기본적으로 우리 홈페이지의 SEO(검색엔진최적화)를 하기 위해서 입니다. 검색을 했을 때 상단에 노출되게 만드는 모든 것이 SEO에 속한다고 보시면 됩니다.

robots.txt 는 검색 로봇(웹 크롤러)의 과도한 크롤링 방지할 수 있습니다.

웹 크롤러가 우리 사이트에 방문해서 웹 페이지 url 을 크롤링해 갈 때, robots.txt 파일이 없다면 기본적으로 모든 페이지를 크롤링해 갑니다. 그러다보면 중복된 링크등 불필요한 링크들을 가져가게 되고, 이 불필요한 링크들을 색인하고 처리하는데에 있어서 너무 많은 User Agent(사용자 에이전트)를 받은 검색엔진이 과부화가 걸릴 수 있습니다. 이러한 과정은 전부 에너지를 쓰는 과정으로 불필요한 에너지를 낭비하게 만드는 홈페이지를 서치엔진은 안좋게 평가할 수 있고, 그렇게 되면 상위노출이 어려워질 수 있습니다.

robots.txt 는 빠르게 '웹 페이지'가 색인되게 할 수 있습니다.

하루에 사용하는 크롤링 예산(Crawl Budget)을 줄여서 웹 페이지가 빠르게 색인될 수 있도록 만들 수 있습니다.

웹 크롤러는 모든 과정을 한번에 처리할 수 있는 것이 아니기 때문에 크롤링에는 속도적으로 한계가 있습니다. 그래서 하루에 크롤링할 수 있는 숫자에 한계가 있는 것입니다. 그것을 크롤링 예산이라고 부릅니다. 이 예산을 너무 과도하게 사용하게 된다면, 중요한 업데이트를 하고 바로 반영해주길 바랄 때, 크롤링 예산이 부족해 새로운 URL 의 검색 결과에 반영되지 않을 수 있고, 빠르게 색인될 수 없습니다.

robots.txt 파일을 업로드 해서 크롤러에게 보여준다면, 필요없는 사이트같은 경우 수집을 건너 뛰어서 필요없는 에너지 낭비를 줄이고, 크롤링 과정을 더 빠르게 할 수 있게 만들 수 있습니다. 크롤링 과정이 빨라지면서 우리가 홈페이지에 중요하게 새로만든 페이지를 더 빠르게 검색에 노출 시킬 수 있게 됩니다.

robots.txt 는 '검색 엔진'에게사이트맵(sitemap.xml)의 위치를 알려줄 수 있습니다.

링크를 타고 다니면서 이동하는 웹 크롤러의 특성상 홈페이지가 조금만 복잡해져도 링크들 사이를 왔다갔다 하면서 크롤링 해야할 페이지를 찾지 못하게 되는 경우가 있습니다. 그 때 필요한 것이 사이트 맵입니다.

사이트 맵은 우리 홈페이지의 지도역할을 합니다. 링크들이 어떤 형식으로 퍼져있는지를 정리해놓은 지도입니다. 이 사이트 맵을 크롤링러가 가지고 홈페이지를 수색한다면 더 빠르고 정확하게 새로운 콘텐츠들을 수집해서 나갈 수 있게 됩니다.

robots.txt 파일에는 사이트맵이 어디있는지 위치를 적어넣을 수 있습니다. 홈페이지에 방문하자마자 robots.txt 파일을 받아보고, 거기에 사이트맵 주소가 적혀있으면 사이트 맵을 가지러 가서 효율적인 홈페이지 크롤링 장비를 착용한 채로 크롤링을 하게 되는 것입니다.

robots.txt 규칙, 만드는 방법

지금까지는 robots.txt 가 무엇인지, 크롤링이 무엇인지, 사이트맵이 무엇인지에 관해서 알아보았습니다. 지금부터는 robots.txt 를 어떻게 만드는지에 대해 자세하게 설명 드리겠습니다. 천천히 꼼꼼하게 보시고 필요한 부분을 잘 설정하셔서 만드시길 바랍니다.

robots.txt 파일은 '일반 텍스트 파일'로 작성하시면 됩니다

우선 기본적으로 robots.txt 파일은 일반 텍스트 파일(.txt)로 만드시면 됩니다. 일반 텍스트 파일을 만드는 방법에는 여러방법이 있지만 모두가 쉽게 사용할 수 있고, 따로 다운로드 받지 않아도 되는 '메모장'을 사용해주시면 되겠습니다.

robots.txt 파일에서 지켜야할 규칙, 기초적인 문법 그리고 예시

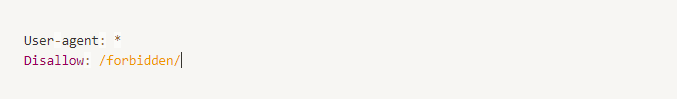

robots.txt 는 기본적으로 사람이 아닌 컴퓨터가 읽고 인식하는 파일입니다. 그렇기 때문에 정해진 형식과 문법에 따라서 만들어 주지 않으면 컴퓨터가 인식하지 못하게 됩니다. 가장 기본적인 문법은 다음과 같습니다.

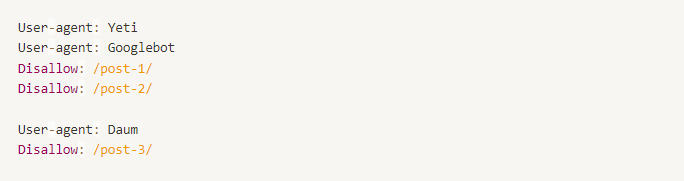

User agent 는 명령을 받을 대상을 적는 칸입니다. 여기에 위 사진같이 *표를 적어넣게 되면, 방문하는 모든 크롤러가 대상이 됩니다.

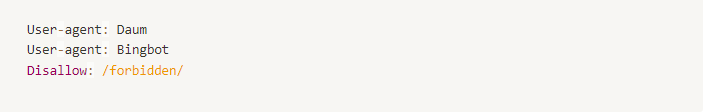

User agent 에 쓸 수 있는 것은 검색 엔진의 크롤러 이름입니다. *를 쓰면 모든 크롤러가 명령에 따르게 되지만, 특정한 사이트에서의 노출을 피하고자 하는 경우, 그 사이트의 크롤러 이름을 User agent 안에 적어 넣어주시면 되겠습니다. 사이트별 크롤러 이름은 다음과 같습니다.

구글(Google) : Googlebot

네이버(Naver) : Yeti

다음(Daum) : Daum

빙(Bing) : Bingbot

만약에 다음과 빙 크롤러에게 /forbidden/폴더에 제한 명령을 내리고 싶다면 다음과 같이 연속적으로 적어주시면 됩니다.

Disallow 는 크롤링을 하지 말아야 할 폴더를 적어넣는 칸입니다. 이 폴더 안에 들어있는 모든 링크들은 크롤링이 되지 않습니다.

기본적으로 '검색 엔진'과 연결한 홈페이지 내부에 있는 페이지는 크롤링의 대상이 됩니다. 그렇기 때문에 어떤 것을 따로 허락해줄 필요는 없고, 가져가면 안되는 부분만 Disallow 안에 적어서 표시해 주면 됩니다.

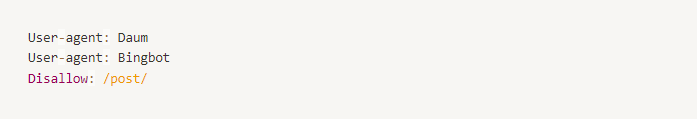

Disallow 안에는 내가 제한하고 싶은 '루트 디렉토리'를 적어 넣으시면 됩니다. 지금 현제 블로그의 주소는 http://backlinkpro.kr/post/robots-txt 인데, 이 링크는 http://backlinkpro.kr/post/ 라는 특정 폴더 안에 속해있다고 생각하시면 됩니다. 이때 /post/ 가 디렉토리 입니다.

예를 들어 위 그림처럼 disallow: /post/ 라고 적어주시게 되면 /post/ 안에 속해있는 블로그 글들을 검색엔진은 크롤링해가지 않게 되고, 그러면 외부에 노출되지 않는 개인 정보 보호가 되는 블로그를 쓸 수 있게 되는 것입니다.

그렇다면 조금 복잡한 예를 들어 보겠습니다.

네이버와 구글에게 /post-1/과 /post-2/의 크롤링을 제한하고, 또 네이버 그리고 다음에게 /post-3/의 크롤링을 제한하는 코드는 다음과 같습니다.

이제 어떻게 작성해야 하는지 아시겠지요?

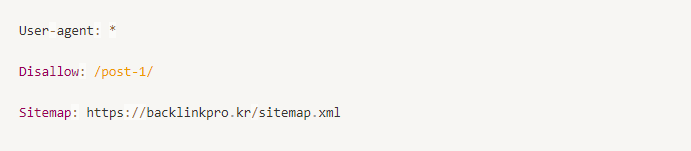

robots.txt 파일에 sitemap.xml 지정

그리고 이제 robots.txt 에 사이트맵의 주소를 넣어줄 차례입니다. 보통 사이트맵 URL 은 홈페이지 주소 뒤에 /sitemap.xml 과 같은 형식으로 url 이 형성되어 있습니다. (사이트 맵이 없으시다면 만드는 방법을 자세하게 작성해 놓은 포스팅이 있으니 확인해보시길 바랍니다.) 그러면 이제 맨 밑에 주소를 이렇게 추가해 주시면 되겠습니다.

Sitemap: http://backlinkpro.kr/sitemap.xml

이렇게 전부 작성하셨다면, 파일을 다른이름으로 저장을 눌러주시고, 반드시 파일 이름을 robots.txt 라고 저장해주세요. 만약에 파일을 업로드 한 이후에도 파일을 찾을 수 없는 경우 robots.txt 라는 이름으로 저장하지 않았을 수 있습니다.

웹페이지 robots.txt 파일 업로드 하는 방법

이제 파일을 원하는 방식으로 작성하시고 저장까지 하셨다면, 이번에는 업로드를 할 차례입니다.

FTP 프로그램(파일질라)사용

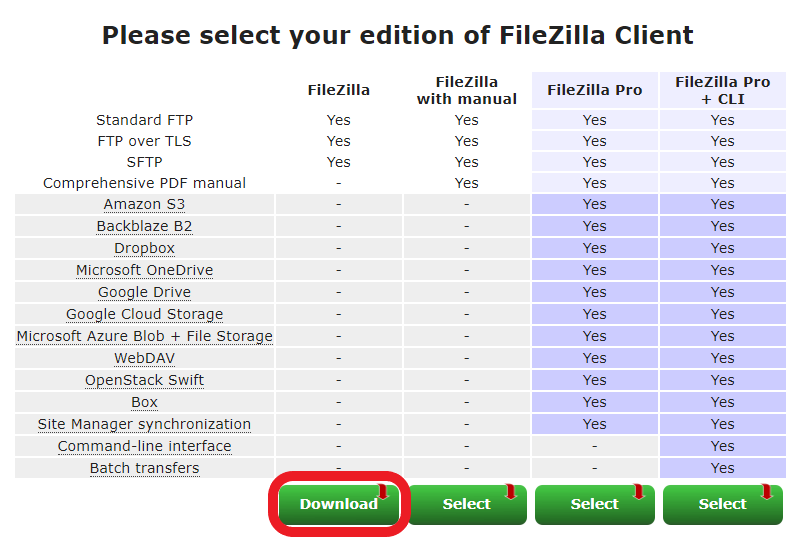

업로드는 보통 FTP(File Transfer Protocol)을 사용해야 합니다. FTP 프로그램 중에서 가장 많이 사용되고 있는 것은 파일질라(FileZilla)입니다. 이제 파일질라를 통해서 업로드 하는 방법을 알아보도록 합시다.

우선 홈페이지에 방문하셔서 왼쪽의 Download FileZilla Client를 눌러주시기 바랍니다.

왼쪽 버튼을 눌러서 진행해주시고

다음과 같은 이미지 창이 나오면, robots.txt 파일을 업로드 하는 것은 무료버전으로도 충분하기 때문에 가장 왼쪽 버튼을 눌러주시고, 다운받아서 설치해주세요.

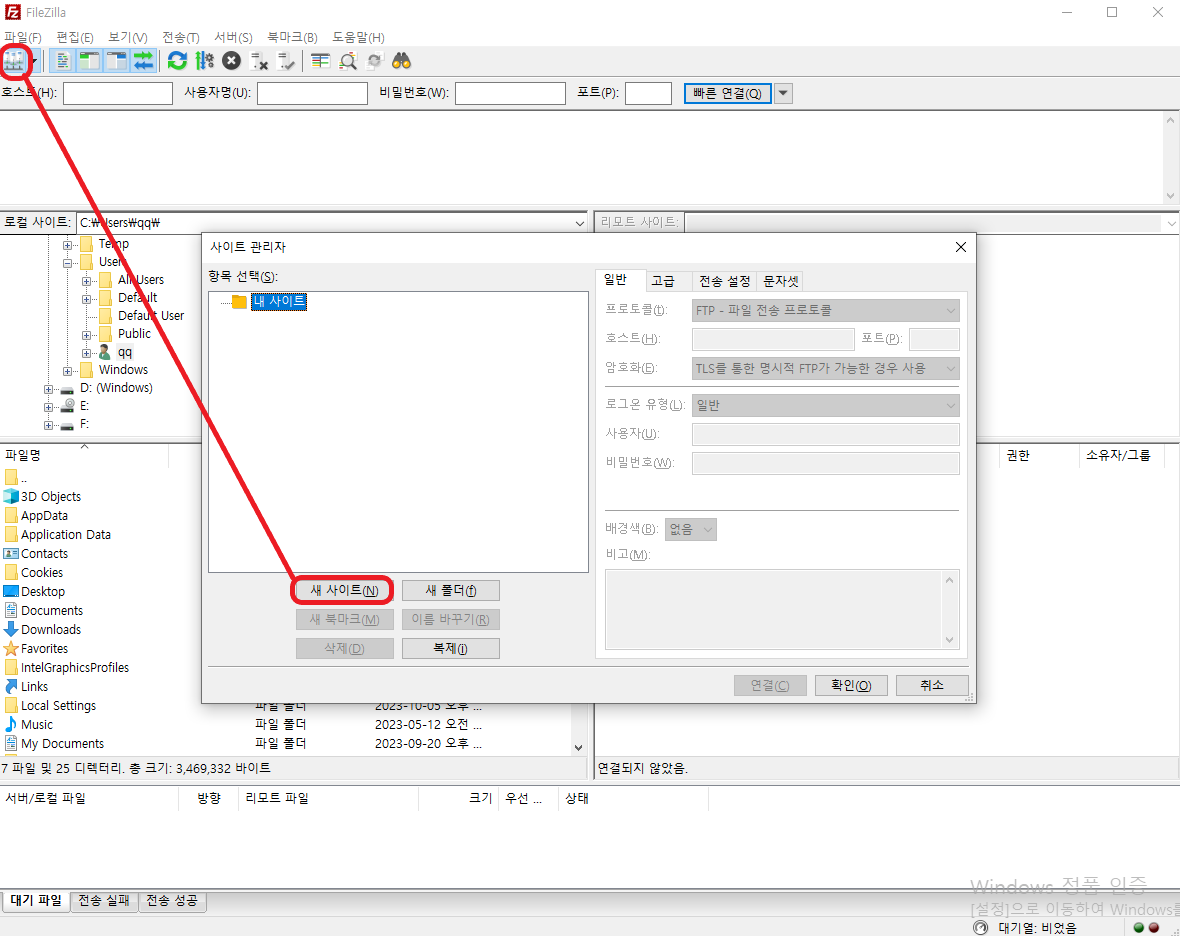

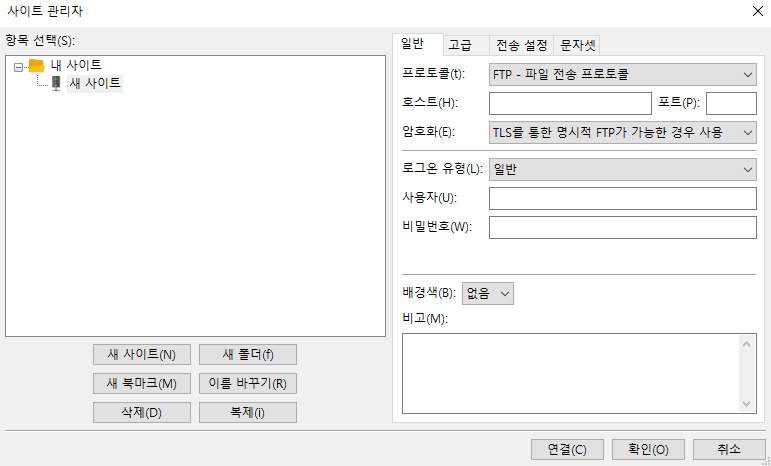

이제 파일질라에서 우리 홈페이지를 연결해야 합니다. 왼쪽위에 그림을 클릭한 후에 나오는 페이지에서 새 사이트를 클릭해주세요.

이제 우리 사이트의 FTP를 연결해주시면 됩니다.

호스트에는 FTP 주소를 넣어주시면 됩니다.

포트에는 프로토콜을 FTP로 설정하셨다면 21을 SFTP를 설정하셨다면 22를 넣어주세요.

사용자에는 FTP서버 접속 사용자 ID를 넣어주시고, 비밀번호에는 서버 접속 비밀 번호를 넣어주시면 됩니다.

다 완료 되셨으면 연결을 눌러주세요.

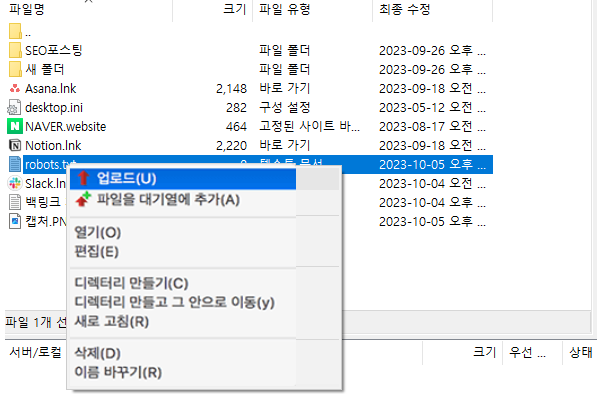

이제 우리가 만들어 놓은 robots.txt 파일을 찾아서 오른쪽 클릭을 한 후에 업로드를 해주시면 됩니다.

robots.txt 파일 업로드 확인 방법

이제 업로드를 다 하셨으면 잘 업로드 되었는지 확인 검색을 해봐야겠죠?

robots.txt 파일의 업로드 확인 방법은 간단합니다.

주소창에 우리 홈페이지의 URL 을 입력하고 그 뒤에 /robots.txt 를 입력해주시면 됩니다.

구글로 예를 들어 보면

https://www.google.com/robots.txt

이렇게 검색창에 쳐보시면 내가 설정하고 넣어놓은 robots.txt 파일에서 어떤 정보들이 주어지는지 볼 수 있습니다.

함께 읽으면 좋은 글

▶ SEO 업체 선정, 무조건 성공하는 5가지 방법

▶'구글 상위 노출' 핵심 전략 총정리

▶ 백링크(Backlink)란? 핵심 개념 총정리